ضرورت رفع مشکلات خودروهای خودران

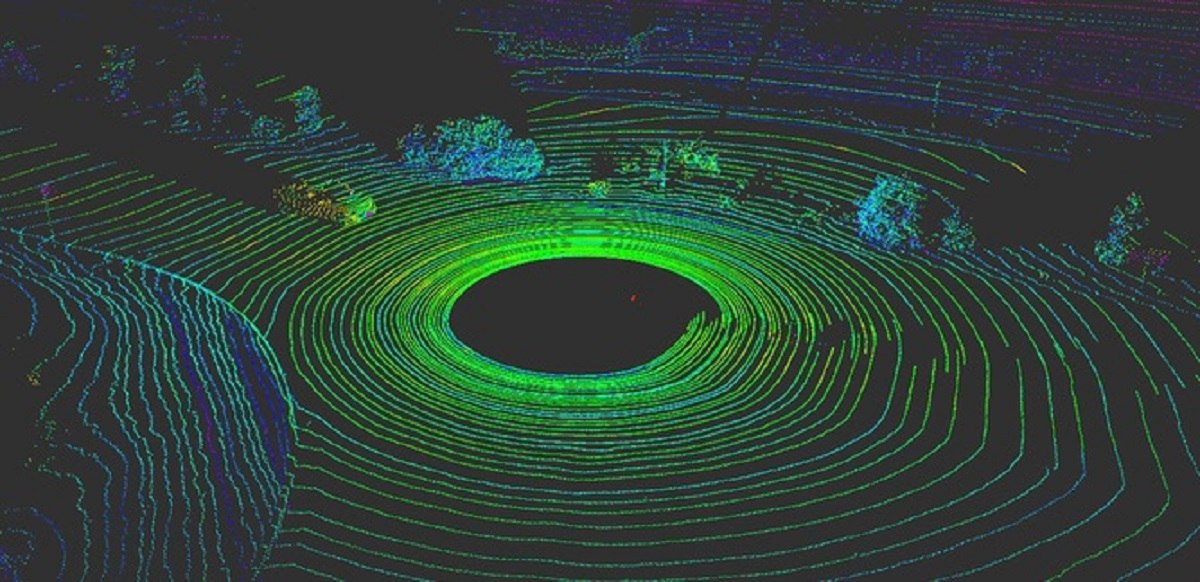

در این جا میبینیم که چگونه وسایل نقلیه خود ران میتوانند برای "دیدن" موانعی که وجود ندارند فریب بخورند.

هیچ چیز برای یک وسیله نقلیه خود ران مهمتر از آن نیست که حواسش به اتفاقات پیرامون خودش باشد. مانند رانندگان انسانی، وسایل نقلیه خود ران نیاز به توانایی تصمیم گیری فوری دارند.

امروزه اکثر وسایل نقلیه خود ران برای درک جهان به حسگرهای مختلفی تکیه دارند. اکثر سیستمها از ترکیبی از دوربینها، سنسورهای راداری و سنسورهای LiDAR (light detection and ranging)(تشخیص نور و دامنه) استفاده میکنند. کارهایی که در آزمایشگاه تحقیق OpenAI انجام شده است نشان میدهد که مدلهای یاد گیری ماشین در برابر سیگنالها یا ورودیهای دستکاری شده خاص آسیب پذیر هستند. در بورد، رایانهها این دادهها را به هم متصل میکنند تا نمایی کاملی از اتفاقات اطراف خودرو ایجاد کنند. بدون این دادهها، وسایل نقلیه خود ران هیچ امیدی به حرکت ایمن در جهان ندارند. اتومبیلهایی که از سیستمهای سنسور چندگانه استفاده میکنند هم بهتر کار میکنند و هم ایمنترند - هر سیستم می تواند به عنوان یک چک کننده برای دیگر سیستمها عمل کند - اما هیچ سیستمی از حمله در امان نیست.

متأسفانه، این سیستمها ایمن از حماقت نیستند. سیستمهای درک مبتنی بر دوربین را میتوان با قرار دادن برچسب روی علائم راهنمایی و رانندگی به راحتی فریب داد تا معنای آنها به طور کامل تغییر یابد.

کار ما، از گروه تحقیقاتی RobustNet در دانشگاه میشیگان با دانشمند رایانه Qi Alfred Chen از UC Irvine و همکارانش از آزمایشگاهSPQR ، نشان داده است که سیستم درک مبتنی بر LiDAR نیز میتواند شامل این حماقت شود.

با فریب استراتژیک سیگنالهای سنسورLiDAR ، این حمله قادر است سیستم درک مبتنی بر LiDAR خودرو را فریب دهد تا یک "مانع" که وجود ندارد را ببیند. در صورت بروز چنین اتفاقی، وسیله نقلیه میتواند با مسدود کردن ترافیک یا ترمز ناگهانی باعث تصادف شود.

سیگنالهای LiDARفریب دهنده

سیستمهای درک مبتنی بر LiDAR دو مؤلفه دارند: سنسور و مدل یاد گیری ماشین که داده های سنسور را پردازش میکند. یک سنسور LiDAR با انتشار یک سیگنال نوری فاصله بین خود و محیط اطراف خود را با اندازه گیری مدتی که طول میکشد تا آن سیگنال از یک شیء خارج شود و به سنسور منعکس شود محاسبه میکند. این مدت زمان رفت و برگشت همچنین به عنوان "زمان پرواز" شناخته میشود.یک واحد LiDAR دهها هزار سیگنال نوری در ثانیه ارسال میکند. سپس مدل یاد گیری ماشینِ آن، از پالسهای برگشتی برای ترسیم تصویری از جهان اطراف وسیله نقلیه استفاده میکند. این شبیه روشی است که یک خفاش از موقیت یابی صوتی (echolocation) استفاده میکند تا بداند موانع در شب کجاست.

مشکل این است که این پالسها می توانند از بین بروند. برای فریب سنسور، یک مهاجم میتواند سیگنال نوری خود را به حسگر بتاباند. این تمام چیزی است که شما نیاز دارید تا سنسور را گیج کنید.

با این حال، فریب دادن سنسور LiDAR برای "دیدن" "وسیله نقلیهای" که وجود ندارد دشوارتر است. برای موفقیت در این امر، مهاجم باید دقیقاً سیگنالهای شلیک شده بهLiDAR قربانی را زمان بندی کند. این امر باید در سطح نانو ثانیه انجام شود، زیرا سیگنالها با سرعت نور حرکت میکنند. هنگامی که LiDAR محاسبه فاصله را با استفاده از زمان اندازه گیری پرواز انجام میدهد، اختلافات کوچک مشخص میشود.

اگر یک مهاجم با موفقیت سنسور LiDAR را فریب دهد، باید سپس مدل یاد گیری ماشین را هم فریب دهد. کارهایی که در آزمایشگاه تحقیق OpenAI انجام شده است نشان میدهد که مدلهای یاد گیری ماشین در برابر سیگنالها یا ورودیهای دستکاری شده خاص آسیب پذیر هستند – آن چه به عنوان مثالهای نقض شناخته میشوند. به عنوان مثال، برچسبهای مخصوص تولید شده روی علائم راهنمایی و رانندگی میتوانند درک مبتنی بر دوربین را فریب دهند.

ما دریافتیم که یک مهاجم میتواند از یک تکنیک مشابه برای پیشبرد آشفتگیهایی که علیه LiDAR کار میکنند استفاده کند. آنها یک برچسب قابل رؤیت نخواهند بود، بلکه سیگنالهای فریب دهندهای هستند که به ویژه برای فریب مدل یاد گیری ماشین خلق شدهاند که فکر کند موانعی وجود دارد در حالی که وجود ندارد. سنسور LiDAR سیگنالهای جعلی هکر را به مدل یاد گیری ماشین تغذیه می کند، که آنها را به عنوان یک مانع تشخیص میدهد.

مثال نقض – یا شیء جعلی – میتواند برای پاسخگویی به انتظارات مدل یاد گیری ماشین ساخته شود. به عنوان مثال، ممکن است مهاجم سیگنال کامیونی را که حرکت نمیکند ایجاد کند. سپس، برای انجام حمله، میتوانند آن را در تقاطع مستقر کنند یا آن را روی وسیله نقلیهای قرار دهند که جلوی وسیله نقلیه خود ران رانده میشود.

دو حمله احتمالی

برای نشان دادن حمله طراحی شده، ما یک سیستم رانندگی خود ران را انتخاب کردیم که مورد استفاده بسیاری از خودرو سازان قرار گرفته است: بایدو آپولو. این محصول بیش از 100 شریک دارد و با تولیدکنندگان متعددی از جمله ولوو و فورد به توافق تولید انبوه رسیده است.با استفاده از دادههای سنسور دنیای واقعی جمع آوری شده توسط تیم بایدو آپولو، ما دو حمله متفاوت را نشان دادیم. یک واحد LiDAR دهها هزار سیگنال نوری در ثانیه ارسال میکند. سپس مدل یاد گیری ماشینِ آن، از پالسهای برگشتی برای ترسیم تصویری از جهان اطراف وسیله نقلیه استفاده میکند. در وهله اول، "حمله ترمز اضطراری"، ما نشان دادیم که چگونه یک مهاجم میتواند با فریب دادن آن با به فکر انداختن آن برای وجود یک مانع در مسیرش، ناگهان وسیله نقلیه را متوقف کند. در مرحله دوم، "حمله فریز کننده AV"، از یک مانع فریبنده استفاده کردیم تا وسیله نقلیهای که پشت چراغ قرمز متوقف شده بود را فریب دهیم تا بعد از روشن شدن چراغ سبز همچنان متوقف بماند.

امیدواریم که بهره گیری از آگاهی از آسیب پذیریهای سیستمهای درک خودکار رانندگی، زنگ خطر را برای تیمهایی که فن آوریهای خود ران دارند به صدا در آورد. تحقیقات در مورد انواع جدیدی از مشکلات امنیتی در سیستمهای رانندگی خود ران تازه آغاز شده است، و ما امیدواریم که پیش از بهره برداری از بازیگران احتمالاً بد، مشکلات احتمالی بیشتری را کشف کنیم.

منبع: یولانگ کائو، زِد مورلی مائو - University of Michigan

مقالات مرتبط

تازه های مقالات

ارسال نظر

نظرات کاربران

{{Fullname}} {{Creationdate}}

{{Body}}