تصویر: این کد چه کاری انجام می دهد - و معنی آن چیست؟ REDPIXEL.PL/Shutterstock.com

حرفه ای های رایانه تقریباً در همه جبهه های جهان مدرن در خط مقدم هستند. هنگامی که هکرها اطلاعات شخصی صدها هزار نفر را از یک شرکت بزرگ سرقت می کنند، آنها درگیر پاسخ هستند. کار آنها می تواند از زیر ساخت های حیاتی مانند شبکه های برق و خطوط حمل و نقل محافظت کند یا آنها را به خطر بیندازد. و الگوریتم هایی که آنها می نویسند ممکن است تعیین کند چه کسی شغل می گیرد، چه کسی برای وام بانکی تأیید می شود یا چه کسی با وثیقه آزاد می شود.

ما در حال درک فرآیند پیچیده یادگیری مبتنی بر بازخورد هستیم که منجر به اخلاقیات می شود.متخصصان فناوری اولین و آخرین خطوط دفاعی در برابر سوء استفاده از فناوری هستند. هیچ کس دیگری سیستم ها را نمی فهمد و هیچ کس دیگری در موقعیتی نیست که از عناصر خاص داده محافظت کند یا اطمینان حاصل کند که اتصالات بین یک جزء و جزئی دیگر مناسب، ایمن و قابل اعتماد است. در حالی که نقش محاسبات به گسترش ده ها ساله خود در جامعه ادامه می دهد، دانشمندان رایانه برای آن چه در آینده اتفاق می افتد نقش اصلی را دارند.

به همین دلیل بزرگ ترین سازمان دانشمندان و مهندسان رایانه در جهان، انجمن ماشین آلات رایانش، که من رئیس آن هستم، کد اخلاقی جدیدی را برای متخصصان محاسبات صادر کرده است. و به همین دلیل ACM اقدامات دیگری را برای کمک به فناوران در درگیر شدن آنها با سؤالات اخلاقی انجام می دهد.

تأمین منافع عمومی

منشور اخلاقی چیزی فراتر از یک سند روی کاغذ است. صدها نمونه از ارزش ها و معیارهای اصلی وجود دارد که هر عضو یک رشته به آنها وفادار می ماند - از جمله برای اصناف نوازنده و انجمن های تبلیغاتی در فضای باز. قدیمی ترین آیین نامه اخلاقی جهان، همچنین مشهورترین آن است: پزشکان با سوگندنامه بقراط قول می دهند که مسئولانه از بیماران خود مراقبت کنند.

تصویر: متخصصان پزشکی از نظر اخلاقی ملزم هستند نیازها و علایق بیماران خود را در اولویت قرار دهند. الکساندر راثس / Shutterstock.com

یک ذهن روباتی، نرم افزاری است که می توان از آن نسخه پشتیبان تهیه کرد و در صورت نابود یا خراب شدن نسخه اصلی آن را بازیابی کرد یا در بدن دیگری کپی نمود.من گمان می کنم که یکی از دلایل مشهور بودن سوگند بقراط این است که واقعاً چگونه می توان درمان پزشکی شخصی را در پیش گرفت، در حالی که زندگی افراد بلاتکیف و نامشخص است. برای بیماران مهم است که اطمینان داشته باشند مراقبان پزشکی شان منافع آنها را کاملاً در نظر دارند.

از بسیاری جهات، فناوری به طور مشابه، شخصی است. در جامعه مدرن، رایانه ها، نرم افزارها و داده های دیجیتالی همه جا هستند. در لپ تاپ ها و تلفن های هوشمند، رسانه های اجتماعی و کنفرانس ویدیویی قابل مشاهده هستند، اما در دستگاه هایی که به مدیریت زندگی روزمره مردم کمک می کنند، از ترموستات گرفته تا تایمرهای سازندگان قهوه، پنهان هستند. تحولات جدید در وسایل نقلیه خودگردان، شبکه های حسگر و یادگیری ماشین به معنای این است که محاسبات در زندگی روزمره در سال های آینده حتی نقشی محوری تر دارند.

یک حرفه در حال تغییر

به عنوان خالق این فناوری ها، متخصصان محاسبات به ایجاد ریتم های پر جنب و جوش در زندگی مدرن کمک کرده اند. اما هرچه رایانه ها به طور فزاینده ای در تار و پود زندگی درآمیخته می شوند، ما در این حرفه باید شخصاً به انجام خدمات به جامعه از طریق رفتار اخلاقی مجدداً متعهد شویم.آخرین کد اخلاقی ACM در سال 1992 تصویب شد، زمانی که بسیاری از افراد کار محاسبات را کاملاً فنی می دانستند. اینترنت در ابتدای راه بود و مردم تازه فهمیده بودند که ارزش جمع آوری و توزیع اطلاعات به طور گسترده چیست. هنوز سال ها قبل از آن بود که هوش مصنوعی و یادگیری ماشین در خارج از آزمایشگاه های تحقیقاتی کاربردی داشته باشند.

امروزه، کار تکنسین ها می تواند بر روی زندگی و معیشت مردم از راه هایی تأثیر بگذارد که ممکن است ناخواسته، و حتی غیر قابل پیش بینی باشد. من طرفدار ترویج اخلاق به وسیله تربیت نیستم، اما برایم روشن است که هر کسی در زمینه رایانه امروز می تواند از راهنمایی در مورد تفکر و رفتار اخلاقی بهره مند شود.

به روز رسانی ها در کد

کد اخلاقی جدید ACM چندین تفاوت مهم با نسخه 1992 دارد. فرد باید با عواقب ناخواسته کنار بیاید. در دهه 1970 و 1980، تکنسین ها نرم افزار یا سیستم هایی را ساختند که تأثیرات آن محدود به مکان یا شرایط خاص بود. اما طی دو دهه گذشته مشخص شد که با پیشرفت فناوری ها، آنها می توانند در زمینه هایی بسیار متفاوت از هدف اصلی به کار گرفته شوند.روبات ها به سادگی ابزاری هستند که بشر باید مسئولیت آن را به عهده بگیرد.به عنوان مثال، تحقیقات بینایی رایانه ای منجر به ایجاد مدل های سه بعدی اشیاء - و افراد - بر اساس تصاویر دو بعدی شده است، اما هرگز در نظر گرفته نشده بود که همراه با یادگیری ماشینی، در برنامه های نظارتی یا هواپیماهای بدون سرنشین نیز مورد استفاده قرار گیرد. کد اخلاقی قدیمی از توسعه دهندگان نرم افزار می خواست مطمئن شوند که برنامه در واقع همان کاری را انجام می دهد که آنها گفته اند. نسخه جدید همچنین از توسعه دهندگان می خواهد که صریحاً کار خود را ارزیابی کنند تا عوارض جانبی بالقوه مضر یا احتمال سوء استفاده را شناسایی کنند.

مثال دیگر مربوط به تعامل انسان است. در سال 1992، بیشتر نرم افزارها توسط برنامه نویسان آموزش دیده برای اجرای سیستم عامل ها، پایگاه داده ها و سایر توابع محاسباتی اساسی، در حال توسعه بود. امروزه بسیاری از برنامه ها برای ارتباط مستقیم با تعداد بالقوه زیادی از افراد به رابط های کاربری متکی هستند. کد اخلاقی به روز شده شامل ملاحظات دقیق تری در مورد نیازها و حساسیت های کاربران بالقوه بسیار متنوع است - از جمله در بحث مربوط به تبعیض، محرومیت و آزار و اذیت.

تصویر: وقتی رایانه ها به بانکداران کمک می کنند تا برنامه های وام را بررسی کنند، الگوریتم ها باید رفتار اخلاقی با مشتریان داشته باشند. fizkes / Shutterstock.com

نرم افزارهای بیشتر و بیشتری در حال تولید شدن هستند که با کمترین و حتی بدون هیچ گونه درکی یا درکی انسانی اجرا می شوند و نتایجی تحلیلی برای هدایت تصمیم گیری، مانند زمان تأیید وام های بانکی، ایجاد می کنند. خروجی ها می توانند تأثیرات کاملاً ناخواسته اجتماعی داشته باشند، و در مقابل طبقات مختلف مردم کژی داشته باشند - مانند موارد اخیر که پیش بینی داده کاوی در مورد افرادی که وام را به عنوان پیش فرض پرداخت می کنند، تبعیض علیه افرادی را که به دنبال وام های طولانی مدت تر هستند یا در مناطق خاصی زندگی می کنند، نشان می داد. همچنین خطراتی وجود دارد که "مثبت کاذب" خوانده می شود، هنگامی که رایانه دو چیز را به هم متصل می کند که نباید به هم متصل شوند - مانند زمانی که اخیراً نرم افزار تشخیص چهره اعضای کنگره را با عکس های پرسنلی مجرمان مطابقت داد. کد اصلاح شده، از فناوران می خواهد مراقبت ویژه ای داشته باشند تا از ایجاد سیستم هایی با توانایی سرکوب یا محرومیت از حق رای برای کل گروه های مردم جلوگیری کنند.

منطقی است که ترس داشته باشیم، که بدون محدودیت های اخلاقی، روبات ها (یا سایر هوش های مصنوعی) حتی با رعایت دستور العمل های داده شده توسط بشر، ممکن است آسیب بزرگی به کل نسل بشر وارد نمایند.

اخلاقیات زندگی در فناوری

این کد در طول بیش از دو سال مورد تجدید نظر قرار گرفت، از جمله توسط اعضای ACM و افراد خارج از سازمان و حتی خارج از حرفه های محاسبات و فناوری. همه این دیدگاه ها کد را بهتر کردند. به عنوان مثال، یک طراح اسلحه که در استخدام دولت بود پرسید که آیا آن شغل ذاتاً مستلزم نقض کد است؟ در نتیجه متن برای روشن کردن این که سیستم ها باید "مطابق با مصالح عمومی" باشند تغییر یافت.اکنون که کد از رده خارج شده، کارهای بیشتری برای انجام وجود دارد. ACM مخزنی را برای مطالعات موردی ایجاد کرده است که نشان می دهد چگونه تفکر اخلاقی و رهنمودها در انواع موقعیت های دنیای واقعی قابل استفاده است. مجموعه ویدئویی و وبلاگ "Ask An Ethicist" این گروه عموم مردم را به ارسال سناریوها یا موارد مبهم در صورت بروز در عمل دعوت می کند. کلمه نیز در حال توسعه ماژول های آموزشی است به گونه ای که مفاهیم بتوانند از دوره ابتدایی تا دانشگاه در آموزش محاسبات ادغام شوند.

بازخورد بسیار مثبت بوده است. مورد علاقه شخصی من اظهار نظر یک برنامه نویس جوان پس از خواندن کد بود: "حالا من می دانم که اگر رئیس من از من بخواهد دوب اره چنین کاری را انجام دهم چه باید بگویم. "

اصول اخلاقی و رفتار حرفه ای ACM با این جمله آغاز می شود، "اقدامات متخصصان محاسبات جهان را تغییر می دهد." ما نمی دانیم که کد ما به اندازه سوگند بقراط دوام خواهد داشت یا خیر. اما نشان می دهد که چقدر مهم است که جامعه محاسبات جهانی تأثیری که کار ما دارد را درک کند - و تعهد ما را در قبال مصالح عمومی جدی بگیرد.

روبات اخلاقی

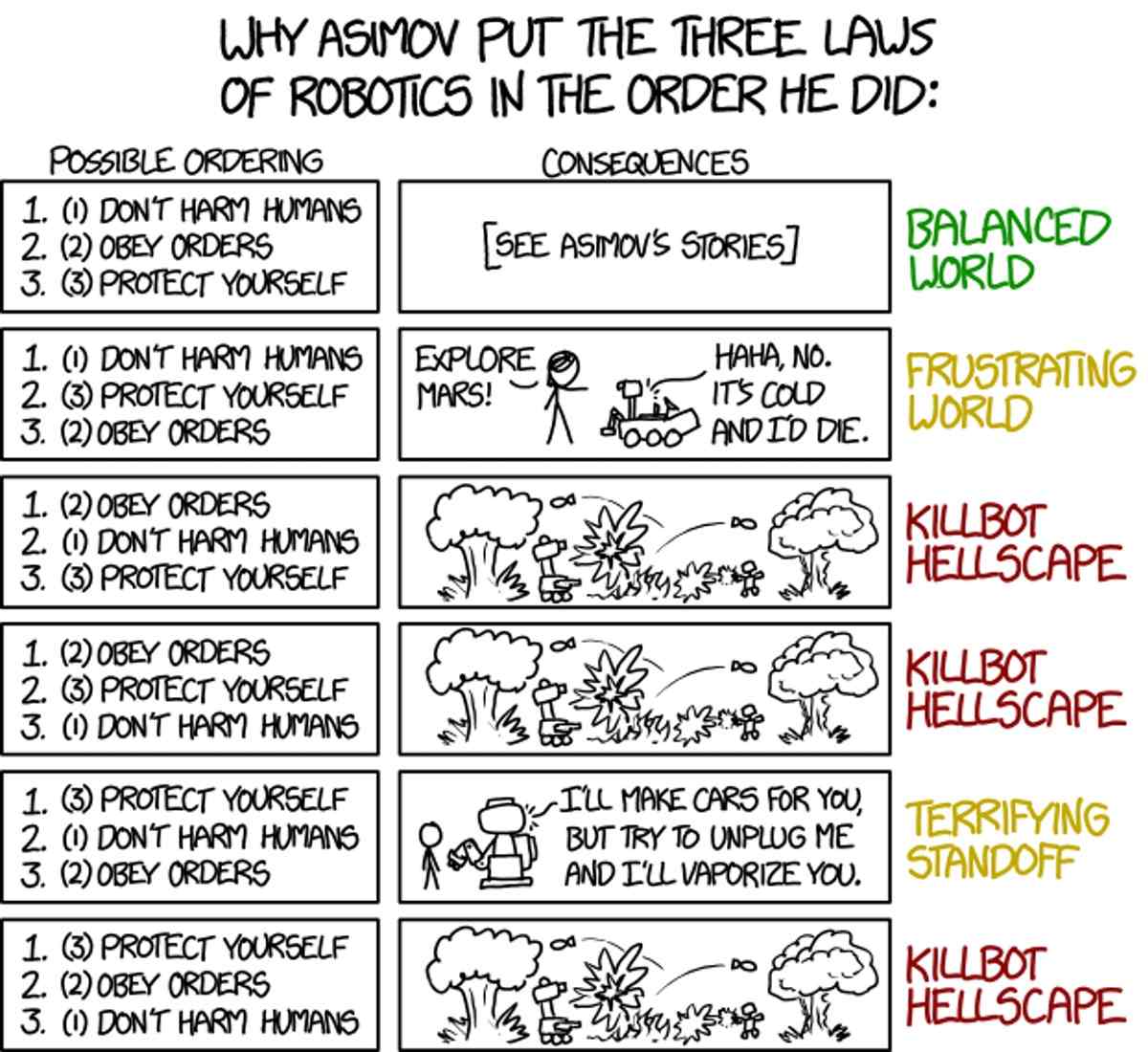

تصویر: یک روبات اخلاقی - به عنوان داستان علمی. exo_duz / flickr ، CC BY-NC

یک روبات ممکن نیست عملاً یا از طریق بی عملی به بشریت آسیب برساند.از آن جا که روبات ها به طور گسترده تری در جامعه ادغام می شوند، باید مطمئن باشیم که رفتار خوبی در بین ما دارند. در سال 1942، آیزاک آسیموف، نویسنده داستان های علمی، تلاش کرد تا چارچوبی فلسفی و اخلاقی برای اطمینان از این که روبات ها به بشریت خدمت می کنند و این چارچوب به دفاع در مقابل تبدیل شدن آنها به فرمانروایان ویرانگر می پردازد ارائه دهد. این تلاش منجر به چیزی شد که تحت عنوان سه قانون روباتیک آسیموف شناخته می شود:

1- یک روبات ممکن نیست عملاً یا از طریق بی عملی به انسان آسیب برساند.

2- یک روبات باید از دستوراتی که انسان به او می دهد تبعیت کند مگر در مواردی که این دستورات با قانون اول مغایرت داشته باشد.

3- یک روبات باید از موجودیت خود محافظت کند به شرطی که این محافظت با قوانین اول یا دوم مغایرت نداشته باشد.

امروز، بیش از 70 سال پس از اولین تلاش آسیموف، ما تجربه بسیار بیشتری در مورد روبات ها داریم، از جمله این که آنها حداقل در شرایط خوب برای ما رانندگی می کنند. ما در حال نزدیک شدن به روزی هستیم که روبات ها در زندگی روزمره ما تصمیم می گیرند که چگونه رفتار کنند. آیا سه قانون آسیموف برای هدایت رفتار روبات ها در جامعه ما به اندازه کافی خوب هستند یا باید روش هایی برای بهبود آنها پیدا کنیم؟

آسیموف می دانست که آنها کامل نیستند

تصویر: Rowena Morrill / GFDL، CC BY-SA

داستان های "من، روبات" آسیموف تعدادی از عواقب ناخواسته و شکست های صریح سه قانون را بررسی می کند. در این داستان های اولیه، با سه قانون به عنوان نیروهایی با قدرت های مختلف رفتار می شود، که می توانند رفتارهای تعادلی ناخواسته ای داشته باشد، مانند داستان های "Runaround" و"Catch that Rabbit" ، که برای حل آنها نیاز به نبوغ انسانی وجود دارد. در داستان "دروغگو!" ، یک روبات تله پاتیک، با انگیزه قانون اول، آنچه را که می خواهند بشنوند به انسان ها می گوید، و نمی تواند آسیب بزرگ تری را که آشکار شدن حقیقت به دنبال خواهد داشت، پیش بینی کند. روبوروانشناس، سوزان کالوین، آن را مجبور به مقابله با این معضل می کند و مغز پوزیترونیک آن را از بین می برد.

اقدامات متخصصان محاسبات جهان را تغییر می دهد.در "فرار!" ، سوزان کالوین قدرت قانون اول را به اندازه کافی کاهش می دهد تا به یک روبات فوق العاده هوشمند اجازه دهد یک روش حمل و نقل بین ستاره ای سریع تر از نور را طراحی کند، حتی اگر باعث مرگ (اما فقط موقتی!) خلبانان انسانی شود. در "درگیری قابل اجتناب"، ماشین هایی که اقتصاد جهان را کنترل می کنند، قانون اول را به عنوان محافظت از بشریت، نه فقط افرادی منفرد، تفسیر می کنند. این پیش درآمدی است بر معرفی دیرتر "قانون صفرم" آسیموف که می تواند جایگزین سه قانون اصلی شود، که به طور بالقوه به یک روبات اجازه می دهد برای منافع بشریت به انسانی آسیب برساند.

0- یک روبات ممکن نیست عملاً یا از طریق بی عملی به بشریت آسیب برساند.

تصویر: بنا به دلایلی متین، قوانین آسیموف از نظم خاصی برخوردار است. Randall Munroe / xkcd ، CC BY-NC

روبات های بدون اخلاق

منطقی است که ترس داشته باشیم، که بدون محدودیت های اخلاقی، روبات ها (یا سایر هوش های مصنوعی) حتی با رعایت دستور العمل های داده شده توسط بشر، ممکن است آسیب بزرگی به کل نسل بشر وارد نمایند.فیلم 1991 "ترمیناتور 2: روز داوری" با یک سناریوی علمی تخیلی شناخته شده آغاز می شود: یک سیستم هوش مصنوعی به نام Skynet جنگ هسته ای را آغاز می کند و تقریباً نسل بشر را نابود می کند. استفاده از Skynet یک تصمیم منطقی بود (زیرا "یک سابقه عملیاتی کامل" داشت). Skynet با یک سرعت تصاعدی هندسی شروع به یادگیری می کند، و سازندگان آن را که سعی در تعطیل کردن آن دارند می ترساند. Skynet مقابله می کند (به عنوان یک سیستم دفاعی مهم، بدون شک برای دفاع از خود برنامه ریزی شده است). Skynet یک راه حل غیر منتظره برای مشکل خود پیدا می کند (از طریق حل مسئله ای خلاقانه، بدون ایجاد محدودیت توسط عقل سلیم یا اخلاق).

کد اصلاح شده، از فناوران می خواهد مراقبت ویژه ای داشته باشند تا از ایجاد سیستم هایی با توانایی سرکوب یا محرومیت از حق رای برای کل گروه های مردم جلوگیری کنند.در واقع نمونه های دنیای واقعی کمتر آخرالزمانی AI در زمینه هوش مصنوعی خارج از کنترل رخ داده است. سیستم های تجارت خودکار پرسرعت به شرایط غیر معمول موجود در بازار سهام پاسخ داده اند و یک چرخه بازخورد مثبت ایجاد می کنند که منجر به "سقوط سریع" می شود. خوشبختانه فقط میلیاردها دلار به جای زندگی میلیاردها نفر از بین رفته است، اما سیستم های رایانه ای درک چندانی از تفاوت ندارند.

به سمت تعریف اخلاقیات روبات

اگرچه هیچ یک از قوانین ساده مکانیکی ثابت رفتار اخلاقی را تضمین نمی کند، اما ما می توانیم درباره خصوصیاتی که یک سیستم معنوی و اخلاقی باید داشته باشد، مشاهداتی انجام دهیم تا به عوامل مستقل (افراد، روبات ها یا هر چیز دیگری) اجازه داده شود که به خوبی با هم زندگی کنند. پیش از این بسیاری از این عناصر از انسان انتظار می رود.این ویژگی ها از منابع مختلفی از جمله اصول روباتیک شورای تحقیقی علوم فیزیکی و مهندسی (EPSRC) (مخفف Engineering and Physical Sciences Research Council ) و کارهای اخیر در زمینه علوم شناختی اخلاق و اخلاق متمرکز بر علوم اعصاب، روانشناسی اجتماعی، روانشناسی رشد و فلسفه الهام گرفته شده است.

EPSRC این موضع را اتخاذ می کند که روبات ها به سادگی ابزاری هستند که بشر باید مسئولیت آن را به عهده بگیرد. در انتهای دیگر طیف این نگرانی وجود دارد که روبات های بسیار هوشمند و فوق العاده قدرتمند می توانند ناگهان ظهور کرده و سرنوشت نژاد بشر را، چه خوب و چه بد، کنترل کنند. در لیست زیر، یک راه میانه تعریف شده است، و توصیف می شود که چگونه روبات های هوشمند آینده، مانند کودکان، باید یاد بگیرند، و چگونه باید مطابق با استانداردهای جامعه ما رفتار کنند.

* اگر روبات ها (و سایر هوش های مصنوعی) به طور فزاینده ای در جامعه ما مشارکت داشته باشند، پس از آن همانند مردم نیز باید از قوانین معنوی و اخلاقی پیروی کنند. برخی از این قوانین در قوانین ضد قتل، دزدی، دروغ گفتن و رانندگی در سمت اشتباه خیابان گنجانده شده است. برخی دیگر رسمیت کمتری دارند اما با این وجود از اهمیت بالایی برخوردارند، مانند مفید بودن و همکاری در صورت بروز فرصت.

* بعضی از موقعیت ها نیاز به قضاوت و واکنش سریع اخلاقی دارند - به عنوان مثال، کودکی که به ترافیک برخورد می کند یا فرصتی که برای جیب بری یا زدن کیف پول پیش آمده است. قوانینی ساده می توانند پاسخ خودکار را به صورت بلادرنگ فراهم کنند، زمانی که فرصتی برای مشورت و تجزیه و تحلیل هزینه و سود وجود ندارد. (روزی ممکن است روبات ها در حالی که بسیار سریع تر از آنچه انسان تصور می کند پیشرفت می کنند، به هوش سطح انسان برسند و امکان بررسی دقیق در میلی ثانیه را فراهم می کنند، اما آن روز هنوز نرسیده است و ممکن است در آینده دورتر باشد.)

مشخص شد که با پیشرفت فناوری ها، آنها می توانند در زمینه هایی بسیار متفاوت از هدف اصلی به کار گرفته شوند.* پاسخ سریع ممکن است همیشه پاسخ درستی نباشد، بلکه ممکن است پاسخ درست پس از بازخورد دیگران یا تأمل دقیق شخصی تشخیص داده شود. بنابراین، نماینده باید بتواند از تجربیات شامل بازخورد و مشورت، و در نتیجه ایجاد قوانین جدید و بهبود یافته، بیاموزد.

* برای بهره مندی از بازخورد دیگران در جامعه، روبات باید بتواند تصمیمات خود را در باره اقدامات اخلاقی توضیح داده و توجیه کند، و توضیحات و انتقادات دیگران را درک کند.

* با توجه به این که هوش مصنوعی از اشتباهات خود می آموزد، باید در مورد این که چقدر قدرت به آن می دهیم احتیاط کنیم. ما انسان ها باید اطمینان حاصل کنیم که طیف وسیعی از موقعیت ها را تجربه کرده و با پاسخ های خود ما را راضی کرده و اعتماد ما را جلب کرده است. اشتباه مهمی که بشر با "Skinet" در "نابودگر 2" مرتکب شد در واگذاری کنترل زرادخانه هسته ای بود.

* اعتماد و امانت، باید توسط روبات به دست آید. اعتماد از طریق تجارب گسترده به آهستگی حاصل می شود، اما با یک تصمیم بد تنها می تواند به سرعت از بین برود.

* همانند یک انسان، هر زمان که یک روبات عمل می کند، انتخاب آن عمل در آن شرایط سیگنالی را به بقیه افراد در مورد چگونگی تصمیم گیری آن عامل و بنابراین قابل اعتماد بودن آن می فرستد.

امروزه، کار تکنسین ها می تواند بر روی زندگی و معیشت مردم از راه هایی تأثیر بگذارد که ممکن است ناخواسته، و حتی غیر قابل پیش بینی باشد.* یک ذهن روباتی، نرم افزاری است که می توان از آن نسخه پشتیبان تهیه کرد و در صورت نابود یا خراب شدن نسخه اصلی آن را بازیابی کرد یا در بدن دیگری کپی نمود. اگر روبات هایی از یک نوع خاص دقیقاً تکرار یکدیگر باشند، ممکن است لازم نباشد اعتماد به صورت جداگانه کسب شود. اعتمادی که یک روبات به دست آورده است (یا از دست داده است) توسط سایر روات های مشابه نیز قابل اشتراک است.

* رفتار اخلاقی و خوب با دیگران همان مسئولیت اخلاقی نیست. فقط انسان های بالغ ذی صلاح می توانند مسئولیت کامل اعمال خود را بر عهده بگیرند، اما ما انتظار داریم کودکان، حیوانات، شرکت ها و روبات ها به بهترین نحو رفتار کنند.

معنویت و اخلاقیات انسانی را کودکان طی سال ها می آموزند، اما ماهیت خود معنویت و اخلاقیات با تغییر جوامع تغییر می کند و طی دهه ها و قرن ها تکامل می یابد. هیچ یک از قوانین ساده اخلاقی، چه سه قانون آسیموف یا ده فرمان، نمی تواند راهنمای کافی برای انسان ها یا روبات ها در جامعه و جهان پیچیده ما باشد. از طریق مشاهداتی مانند مشاهدات فوق، ما در حال درک فرآیند پیچیده یادگیری مبتنی بر بازخورد هستیم که منجر به اخلاقیات می شود.

متخصصان فناوری اولین و آخرین خطوط دفاعی در برابر سوء استفاده از فناوری هستند.

منبع:

چری ام پنکیک، Oregon State University، بنیامین کوئیپرز، University of Michigan